본 포스트에서는 세밀한 객체 검출을 위한 초점 손실 논문에서 발표된 RetinaNet 모델을 살펴보겠습니다.

개요

딥러닝을 기반으로 한 세밀한 객체 검출(dense object detection) 모델은 크게 두 가지로 분류할 수 있습니다. 하나는 YOLO, SSD등으로 대표되는 1차 네트워크(one-stage network), 영역 제안과 객체 분류가 분리되어있는 2차 네트워크입니다. 일반적으로 전자가 후자에 비해 속도가 빠르면서 성능은 낮습니다.

이런 현상이 일어나는 원인은 각 분류 간의 불균형입니다. 1차 네트워크는 영상 전체에서 후보 위치를 샘플링하는데 대부분의 영상은 의미있는 객체가 영상의 일부분만을 점유하고 대부분은 무관계한 배경입니다. 학습 과정에서 대부분의 시간 동안 이러한 쉬운 음성 샘플을 학습하기 때문에 학습이 비효율적이고 비일반적으로 진행됩니다. 2차 네트워크는 영역 제안 단계에서 과다한 샘플을 필터링할 수 있으므로 이 문제의 영향을 적게 받습니다.

초점 손실

논문에서는 이 문제를 해결하기 위해 객체 검출 및 분류에 일반적으로 사용되는 크로스 엔트로피 손실 함수 대신 초점 손실(focal loss) 함수를 대신 사용하기를 제안합니다.

기존 크로스 엔트로피와 비교했을때 초점 손실 함수의 차이점은 변조 인수 가 추가되어 있다는 것입니다. 이 인수가 쉬운 샘플의 중요도를 하강시키며 어려운 샘플들의 학습에 집중하게 만듭니다. 는 조절 가능한 초점 인수이며 0보다 큰 값이여야 합니다. (이면 크로스 엔트로피 함수와 동일해집니다) 논문에서 범위에서 실험 결과 에서의 성능이 가장 우수했다고 합니다. 초점 인수의 값이 클수록 쉬운 샘플이 모델에 미치는 영향이 줄어듭니다.

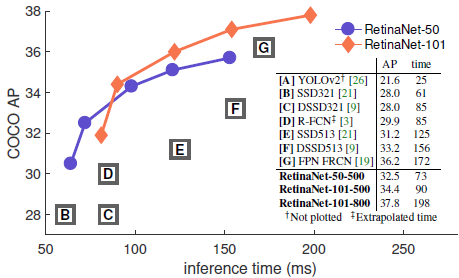

이 초점 손실 함수의 성능을 증명하기 위해 논문에서는 RetinaNet이라는 새로운 객체 검출 모델을 디자인하여 그 성능을 보였습니다. FPN을 기반으로 하여 앵커 박스를 사용하는 간단한 1차 네트워크입니다. 백엔드 망은 ResNet-50과 ResNet-101을 사용하였습니다.

COCO 데이터셋에서 평균 정확도(AP)와 예측 시간을 비교한 결과입니다. 기존에 성능이 가장 우수하다고 알려졌던 FPN FRCN도 그래프에 포함되어 있는데 같은 소요시간 기준으로 RetinaNet의 정확도가 가장 우수함을 알 수 있습니다.